Das KI-Update für die Woche 50/51-2025

06.12. - 19.12.

Liebe KI-Enthusiasten,

herzlich willkommen zu einer neuen Ausgabe unseres KI-Newsletters, der Sie über die neuesten Entwicklungen und Innovationen in der Welt der künstlichen Intelligenz auf dem Laufenden hält. Dies mal habe ich für Sie die Entwicklungen der beiden Wochen zusammen gelegt, da ich letzte Woche komplett Land unter war. Die Veröffentlichung von Semtuk, unserer KI-Suite, steht kurz bevor 🔥

Wichtigste Punkte heute

🚀 OpenAI GPT-5.2 vs. Google Gemini 3 – Der KI-Kampf der Giganten am selben Tag

💻 Mistral Devstral 2: Open-Source-Coder mit 72% auf SWE-bench erreicht neue Bestleistung

🛡️ Anthropic testet Claude für Chrome – 11,2% Prompt-Injection-Risiko trotz Schutzmaßnahmen

🌌 Bezos vs. Musk: Das Rennen um KI-Rechenzentren im Weltraum beginnt

Viel Spaß

Ihr

Martin Blaha

🔥 Gefällt Ihnen unser Newsletter? Unterstützen Sie unsere Arbeit, in dem Sie uns Ihren Freunden und Kollegen empfehlen:

Produktneuheiten

OpenAI startet GPT-5.2 - neues Top-Modell für Profis

OpenAI hat am 11. Dezember 2025 die GPT-5.2-Modellfamilie vorgestellt, die als fortschrittlichstes Modell für Entwickler und professionelle Anwendungen positioniert wird. Die drei Varianten - Instant für schnelle Aufgaben wie Schreiben und Recherche, Thinking für komplexes Coding, Mathe und Planung sowie Pro für höchste Genauigkeit - bieten einen Kontext von 400.000 Tokens und verbesserte Reasoning-Fähigkeiten. OpenAI betont Fortschritte bei Agenten-Workflows, Coding-Benchmarks und Alltagsnutzung, um gegen Google Gemini 3 anzutreten; Verfügbarkeit erfolgt sofort für ChatGPT-Zahlnutzer und via API.

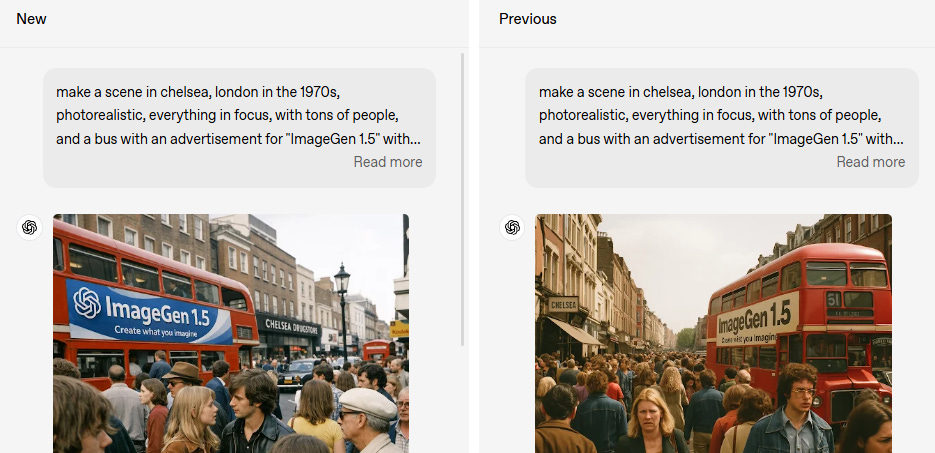

OpenAI lanciert neues ChatGPT-Bildgenerator

OpenAI hat mit “The new ChatGPT Images is here” seinen neuen Flaggschiff-Bildgenerator vorgestellt, der präzisere Bearbeitungen, konsistente Details und bessere Prompt-Treue bietet. Der Model verbessert die Anweisungstreue und genaue Edits, wie im offiziellen Ankündigungsbeitrag beschrieben. Ziel ist es, Nutzern in ChatGPT ein stärkeres Tool für Bildgenerierung zu liefern, verfügbar für Plus-, Pro- und Free-User. Community-Reaktionen auf Reddit loben Fortschritte, kritisieren aber Geschwindigkeit im Vergleich zu Konkurrenz.

OpenAI stellt GPT-5.2-Codex vor - Top-Modell für agentisches Coding

OpenAI hat GPT-5.2-Codex als fortschrittlichstes agentisches Coding-Modell für komplexe Software-Entwicklung und defensive Cybersicherheit vorgestellt. Es steht ab sofort für alle bezahlenden ChatGPT-Nutzer zur Verfügung, während API-Zugang in den kommenden Wochen folgt. Das Modell zielt auf reale Engineering-Aufgaben ab, mit Pilotprogrammen für vertrauenswürdige Profis in der Cybersicherheit; OpenAI betont verantwortungsvolle Bereitstellung.

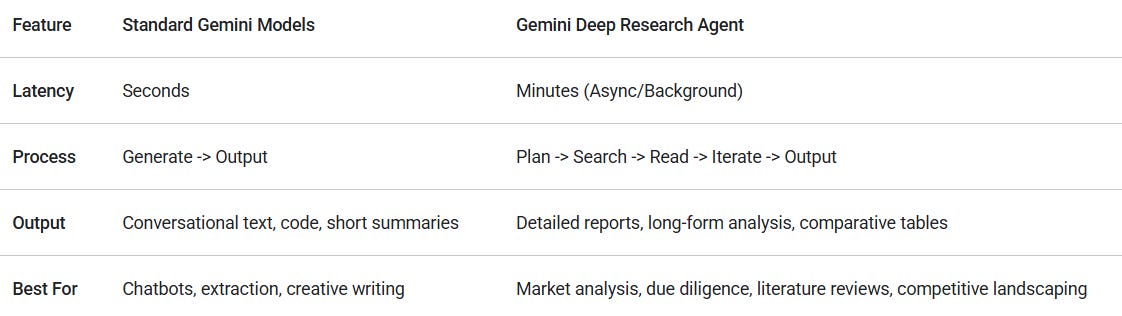

Google aktualisiert Gemini Deep Research - am selben Tag als OpenAI GPT-5.2 rausbringt

Google hat am Donnerstag eine überarbeitete Version seines Forschungsagents Gemini Deep Research auf Basis des Gemini 3 Pro-Modells vorgestellt. Der Agent synthetisiert große Informationsmengen, minimiert Halluzinationen und wird via Interactions API in Apps integriert - bald auch in Google Search, Finance und NotebookLM. Google bewirbt es für Aufgaben wie Due-Diligence oder Arzneimittelsicherheit und führt Benchmarks wie DeepSearchQA durch, wo es OpenAIs ChatGPT 5 Pro knapp schlägt. Am selben Tag launchte OpenAI GPT-5.2 (Codename Garlic), das in Benchmarks besser abschneidet, was Googles Timing spannend macht.

Gemini 3 Flash: Grenzenlose KI-Intelligenz für alle

Google stellt Gemini 3 Flash vor, das neueste Modell der Gemini-3-Familie, das frontier intelligence mit hoher Geschwindigkeit und niedrigen Kosten kombiniert. Es ersetzt Gemini 2.5 Flash als Standardmodell in der Gemini-App und ist weltweit für alle Nutzer kostenlos verfügbar, um Alltagsaufgaben zu optimieren. Das Modell bietet verbesserte Reasoning-, Tool-Use- und Multimodal-Fähigkeiten für komplexe Aufgaben wie 3D-Simulationen oder Code-Generierung - ideal für Entwickler und Unternehmen.

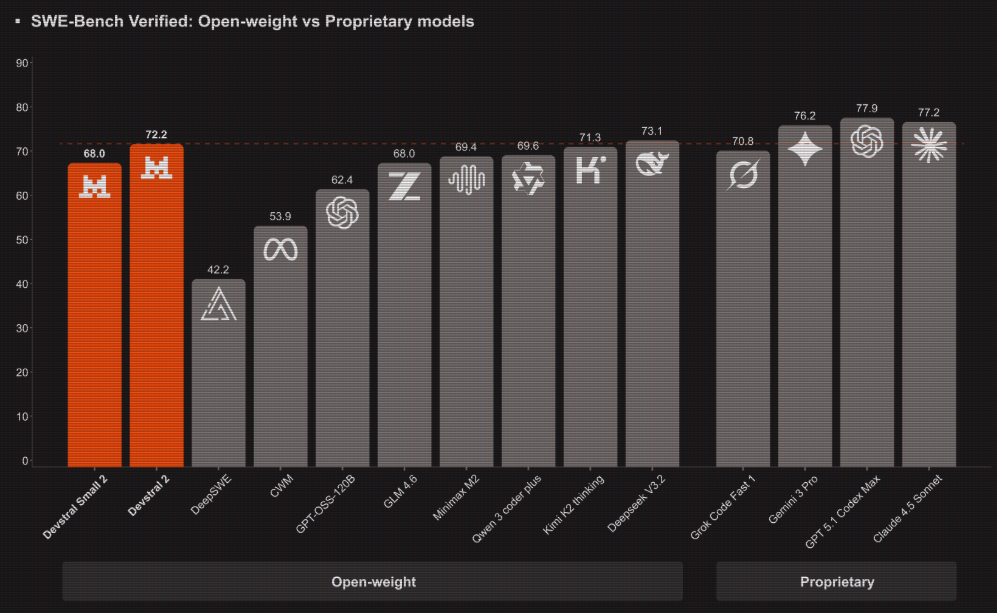

Mistral AI launcht Devstral 2: Top-Open-Source-Coder mit CLI-Tool

Mistral AI stellt Devstral 2 (123B Parameter, modifizierte MIT-Lizenz) und Devstral Small 2 (24B, Apache 2.0) vor - offene Modelle für Code-Agenten. Devstral 2 erzielt 72,2% auf SWE-bench Verified und übertrifft Konkurrenten bei geringerem Ressourcenverbrauch, ideal für Bug-Fixing und Legacy-Modernisierung. Ergänzt wird dies durch Mistral Vibe CLI, ein offenes Terminal-Tool für autonome Codebearbeitung mit Projekt-Kontext und Multi-File-Orchestrierung. Beide sind API-fähig, Devstral Small lokal deploybar; Preise nach Freiphase: 0,40/2,00 USD pro Mio. Tokens (Devstral 2).

Mistral OCR 3: Neue Grenzen in Genauigkeit und Effizienz

Mistral AI stellt mit Mistral OCR 3 ein OCR-Modell vor, das Text und Bilder aus Dokumenten mit höchster Treue extrahiert und Markdown mit HTML-Tabellen ausgibt. Es übertrifft Mistral OCR 2 mit 74% Win-Rate bei Formularen, Handschrift, Tabellen und Scans, schlägt Enterprise-Lösungen und ist mit 2 USD pro 1.000 Seiten günstig (Batch: 1 USD). Das Modell eignet sich für API-Integration und den Document AI Playground zur Strukturierung in JSON. Der Autor betont breite Anwendungen wie Rechnungsverarbeitung und Archivierung.

Claude für Chrome: Pilot gegen Prompt-Injection-Risiken

Anthropic startet einen Pilot für die Chrome-Erweiterung “Claude for Chrome”, um browserbasierte KI-Fähigkeiten zu testen. Claude soll Webseiten sehen, Buttons klicken und Formulare ausfüllen, um nützlicher zu werden - doch Sicherheitsherausforderungen wie Prompt-Injection-Angriffe stehen im Fokus. Ohne Schutzmaßnahmen lag die Angriffserfolgsrate bei 23,6%, mit Permissions, verbesserten System-Prompts und Blocklisten auf 11,2% gesunken. Der Pilot mit 1.000 Max-Plan-Nutzern (Waitlist: claude.ai/chrome) sammelt reale Daten, um Schutzmechanismen zu verfeinern.

Veröffentlichungen und Ankündigungen

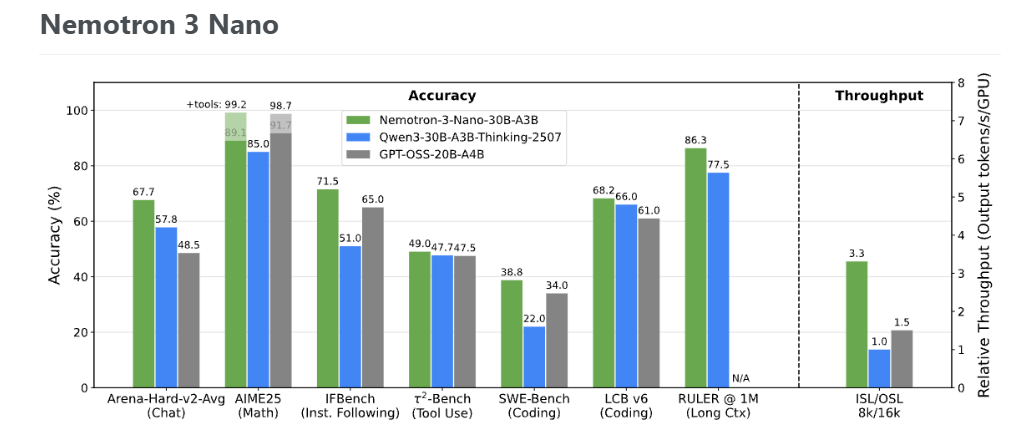

NVIDIA Nemotron 3: Effizienteste offene KI-Modelle für Agenten

NVIDIA stellt die Nemotron-3-Familie vor, die aus Nano, Super und Ultra besteht und höchste Genauigkeit bei agentenbasierten Anwendungen bietet. Nano (3,2B aktive Parameter) übertrifft Modelle wie GPT-OSS-20B und Qwen3-30B-A3B in Benchmarks, mit 3,3x höherem Throughput und bis zu 1M Token Kontextlänge. Es nutzt Hybrid-MoE-Architektur (Mamba-Transformer), LatentMoE und Multi-Token-Prediction. NVIDIA veröffentlicht Nano-Weights, Daten (z.B. Nemotron-CC-v2.1 mit 2,5T Tokens) und Rezepte open source; Super/Ultra folgen bald.

GLM-4.6V: Open-Source-Multimodal-Model mit nativem Tool-Use

Z.ai stellt die GLM-4.6V-Serie vor: GLM-4.6V (106B) für Cloud-Anwendungen und GLM-4.6V-Flash (9B) für lokale Einsätze. Das Modell erreicht 128k-Token-Kontext, State-of-the-Art in visueller Verständnis und Reasoning und integriert erstmals natives Function Calling für multimodale Tools. Es ermöglicht nahtlose Workflows von Perception zu Execution, z. B. Bild-Text-Erstellung oder visuelle Suche.

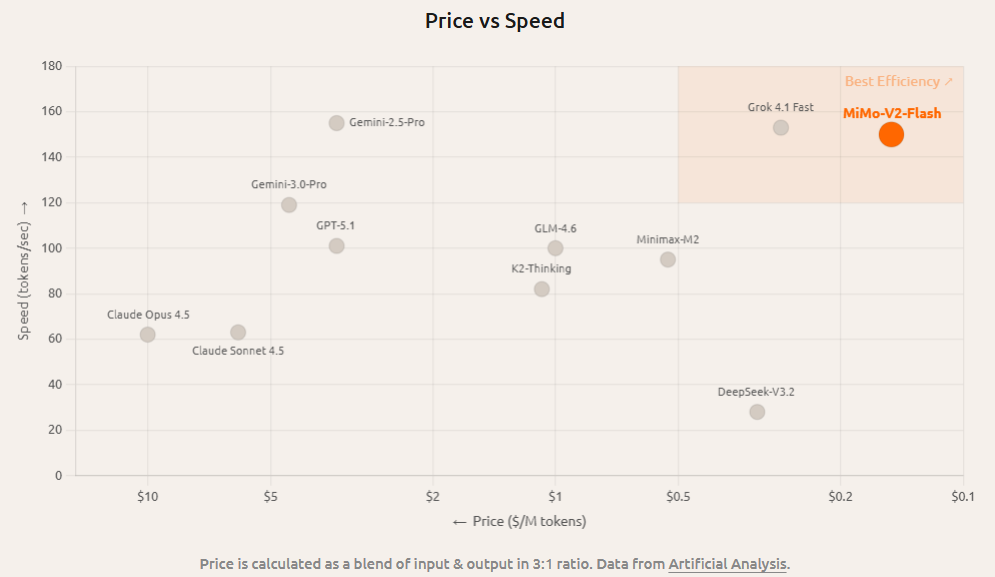

Xiaomi stellt MiMo-V2-Flash vor - ultraschnelles MoE-Modell für Agenten-AI

Xiaomi hat MiMo-V2-Flash open-source veröffentlicht: ein Mixture-of-Experts-Modell mit 309 Milliarden Gesamtparametern, von denen nur 15 Milliarden aktiv sind. Es nutzt eine hybride Attention-Architektur (5:1 Sliding-Window zu Global Attention mit 128-Token-Fenster) und Multi-Token Prediction für bis zu 3x schnellere Inferenz bei 256k Kontextlänge. Die Intention der Autoren ist, ein effizientes Modell für Reasoning, Coding und agentische Szenarien zu bieten, das 150 Token/Sekunde erzeugt bei Kosten von 0,1 USD/Mio. Input-Token. Es konkurriert mit Top-Modellen wie Kimi K2 in Benchmarks.

Chatterbox Turbo: DeepSeek-Moment für Voice AI

Dev Shah von Resemble AI kündigt mit “This is the DeepSeek moment for Voice AI” die Veröffentlichung von Chatterbox Turbo an - einem MIT-lizenzierten Sprachmodell, das ElevenLabs Turbo und Cartesia Sonic 3 übertrifft. Es löst Kompromisse auf: ultraschnell (<150 ms), hochwertig, expressiv mit Paralinguistic-Tags wie [laugh] oder [sigh] und vertrauenswürdig durch PerTh-Wasserzeichen. Die Intention: Open-Source-TTS für Echtzeit-Agenten, Voice-Cloning ab 5 Sekunden Audio und skalierbare Anwendungen vorantreiben.

👉 Mitteilung von Dev Shah auf X

Industrienachrichten

Google DeepMind unterstützt US-Energiebehörde bei Genesis-Mission

Google DeepMind kooperiert mit dem US Department of Energy (DOE), um die Genesis-Mission voranzutreiben - ein nationales Programm zur Beschleunigung wissenschaftlicher Entdeckungen durch KI. Forscher an allen 17 National Laboratories erhalten priorisierten Zugang zu Frontier-AI-Tools wie AI Co-Scientist, das Forschungszeiten von Jahren auf Tage verkürzt und bereits Kandidaten für Leberfibrose-Medikamente vorschlug. Ab 2026 folgen AlphaEvolve, AlphaGenome und WeatherNext. Die Partnerschaft nutzt Gemini for Government, um Herausforderungen wie Fusionsplasma oder Materialforschung zu meistern und die US-Wissenschaft zu boosten.

Chinas “Manhattan-Projekt” für KI-Chips

Reuters berichtet exklusiv, wie China in einem geheimen Shenzhen-Labor ein funktionierendes EUV-Lithographie-Prototyp entwickelt hat, um westliche Abhängigkeiten bei fortschrittlichen AI-Chips zu überwinden. Das Projekt, koordiniert von Huawei mit Tausenden Ingenieuren unter Pseudonymen, wird als Pekings “Manhattan-Projekt” für Halbleiter-Selbstversorgung beschrieben und nutzt Reverse Engineering mit Hilfe eines Ex-ASML-Mitarbeiters. Die Autorin Fanny Potkin beleuchtet die strategische Absicht, Maschinen wie die von ASML (ca. 250 Mio. USD pro Stück) zu ersetzen, essenziell für Chips von Nvidia & Co..

Bezos und Musk im Wettrennen um Rechenzentren im All

Elon Musk (SpaceX) und Jeff Bezos (Blue Origin) treiben den trillionenschweren KI-Data-Center-Boom in den Orbit. Blue Origin entwickelt seit über einem Jahr orbitale KI-Technologie, SpaceX plant Starlink-Upgrades für AI-Computing. Befürworter sehen Vorteile in unerschöpflicher Solarenergie und Vakuum-Kühlung, Skeptiker zweifeln an Kosten und Machbarkeit gegenüber irdischen Zentren.

👉 Artikel bei The Wall Street Journal

Trump stoppt AI-Regeln der US-Staaten

US-Präsident Donald Trump hat einen Executive Order erlassen, der US-Staaten verbietet, eigene Vorschriften für Künstliche Intelligenz durchzusetzen. Der Befehl zielt auf eine einheitliche nationale AI-Politik ab, um Fragmentierung zu verhindern und Innovationen zu fördern. Die Berichterstattung stellt die Kontroverse zwischen föderaler Einheitlichkeit und lokalen Schutzansätzen neutral dar. Dies könnte die AI-Entwicklung beschleunigen, birgt jedoch Risiken für branchenspezifische Regulierungen.

👉 Artikel bei BBC | 👉 Mitteilung von The White House

Zahlen, Studien, Wissenschaft

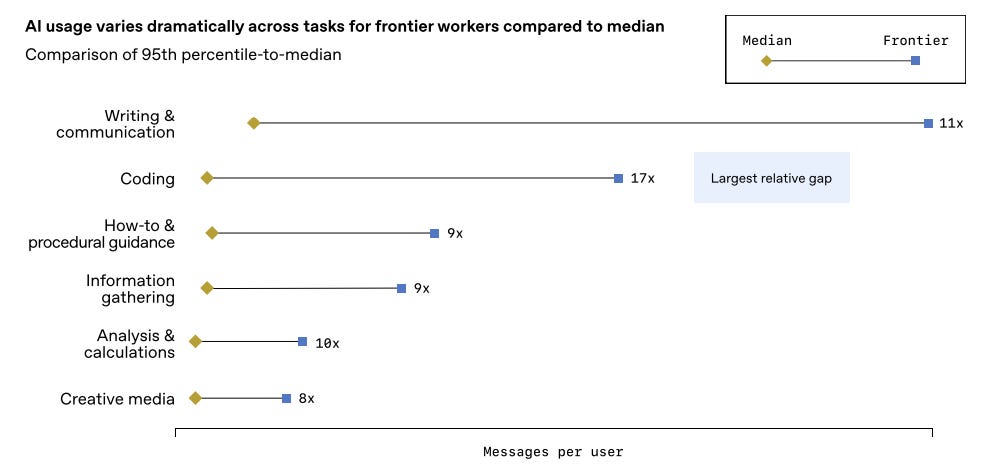

OpenAI-Report: KI-Nutzung in Unternehmen explodiert 2025

OpenAIs „State of Enterprise AI 2025“-Report analysiert Nutzungsdaten von über einer Million Unternehmen und Umfragen mit 9.000 Mitarbeitern. ChatGPT-Nachrichtenvolumen stieg 8-fach, API-Reasoning-Tokens pro Organisation um das 320-Fache. 75% der Nutzer berichten von schnellerer oder besserer Arbeit, mit 40-60 Minuten täglicher Einsparung; AI-Leader erzielen 1,7-fach höheres Umsatzwachstum. Der Report hebt eine wachsende Kluft zwischen intensiven und oberflächlichen Nutzern hervor und betont, dass Organisationsbereitschaft der neue Engpass ist.

OpenAI stellt FrontierScience vor - neuer Benchmark für KI in der Wissenschaft

OpenAI hat FrontierScience eingeführt, einen Benchmark zur Bewertung der Fähigkeiten von KI-Modellen bei expertenleveligem wissenschaftlichem Reasoning in Physik, Chemie und Biologie. Der Test misst Fortschritte hin zu realer Forschungsarbeit und umfasst Hunderte von von Experten verifizierten Fragen. Ziel ist es, AI-Einsatz in der Wissenschaft transparent zu evaluieren und Entwicklungen wie bei GPT-5 zu dokumentieren, ohne Interpretationen des Autors.

Ich wünsche Ihnen ein schönes Wochenende!

Prompt Well and Prosper!

Ihr

Martin Blaha

Das KI-Update ist eine wöchentliche Publikation, die von Martin Blaha (3pconsulting.net) produziert wird. Kontakt- und Geschäftsanfragen gerne über LinkedIn.