Das KI-Update für die Woche 28-2025

05.07. - 11.07.

Liebe KI-Enthusiasten,

herzlich willkommen zu einer neuen Ausgabe unseres KI-Newsletters, der Sie über die neuesten Entwicklungen und Innovationen in der Welt der künstlichen Intelligenz auf dem Laufenden hält.

Wichtigste Punkte heute

🚀 Grok 4 von xAI: Neues Premium-Modell übertrifft alle anderen deutlich – 300$/Monat für Profis

🤖 Reachy Mini: Open-Source-Roboter für 299$ bringt KI auf jeden Schreibtisch

💼 Capgemini kauft WNS für 3,3 Mrd. USD – Fokus auf KI-gestützte Geschäftsprozesse

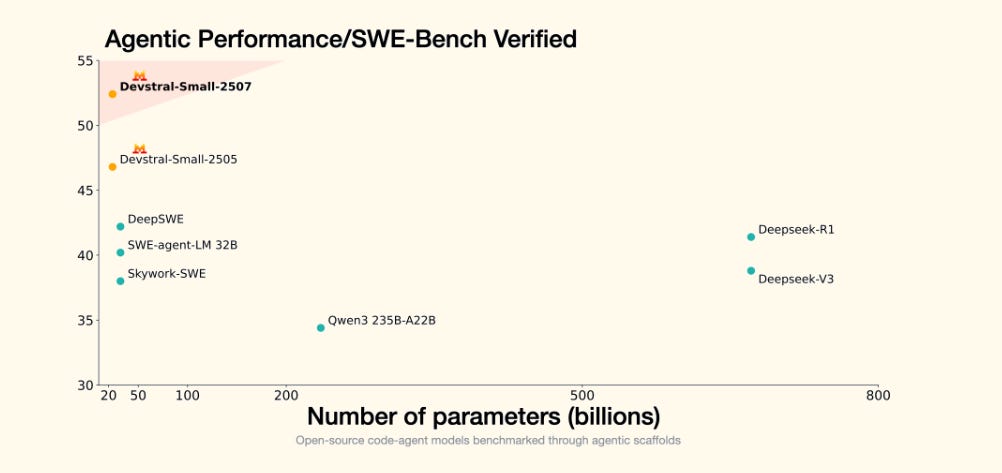

🔬 Mistral Devstral: Neue Coding-KI erreicht 61,6% auf SWE-Bench und übertrifft Konkurrenz

Viel Spaß

Ihr

Martin Blaha

🔥 Gefällt Ihnen unser Newsletter? Unterstützen Sie unsere Arbeit, in dem Sie uns Ihren Freunden und Kollegen empfehlen:

Veröffentlichungen und Ankündigungen

Grok 4 von Elon Musks xAI: Innovativer KI-Meilenstein mit vielversprechendem Premium-Angebot

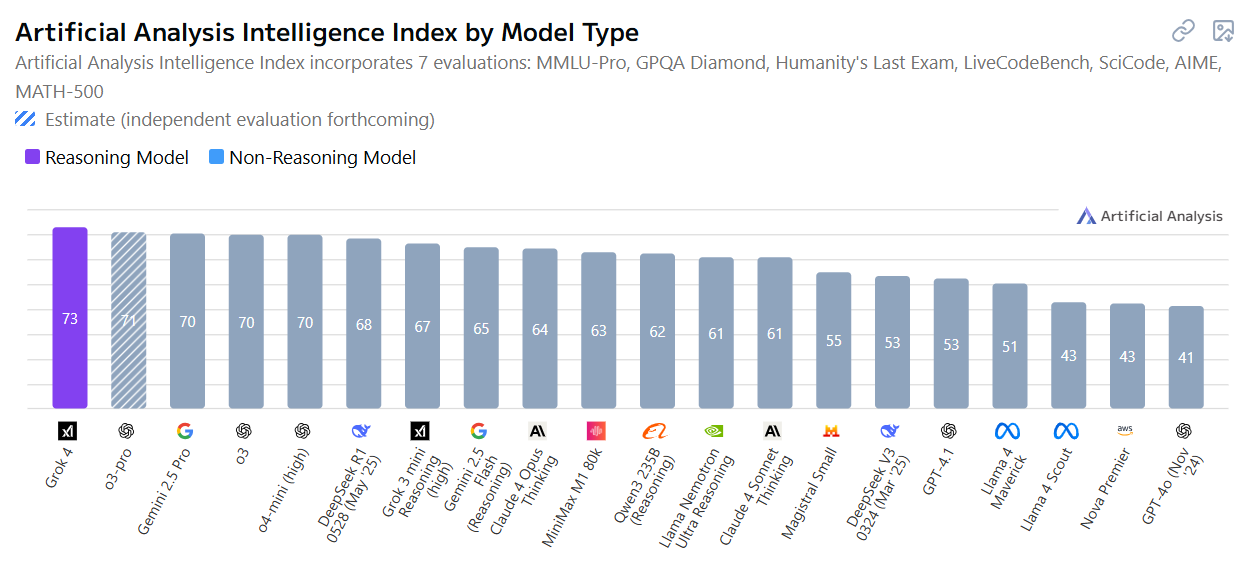

Grok 4 von xAI setzt neue Maßstäbe im Bereich Künstliche Intelligenz: Das Modell erzielt herausragende Ergebnisse in anspruchsvollen Benchmarks wie „Humanity’s Last Exam“ und ARC-AGI-2 und übertrifft damit etablierte Konkurrenten wie Gemini und GPT-4 deutlich. Besonders die „Heavy“-Version, die mehrere KI-Agenten kombiniert, ermöglicht komplexe Problemlösungen und eröffnet vielfältige Anwendungsmöglichkeiten in Forschung und Industrie.

Mit einem Abopreis von 300 $ pro Monat richtet sich Grok 4 vor allem an professionelle Anwender, die höchste Qualität und innovative Funktionen schätzen. Trotz bestehender Herausforderungen in puncto Ethik und Sicherheit zeigt Grok 4 eindrucksvoll, wie schnell sich KI-Technologie weiterentwickelt und welche Chancen sie für die Zukunft bietet. Die Kombination aus Leistungsstärke, Vielseitigkeit und stetiger Verbesserung macht Grok 4 zu einem spannenden Werkzeug für den nächsten Schritt in der KI-Entwicklung.

👉 Artikel bei TechCrunch | 👉 Artikel bei Forbes | 👉 Mitteilung von xAI auf X

👉 Artikel bei Artificial Analysis

Reachy Mini – Der Open-Source-Roboter für alle KI-Entdecker

Reachy Mini ist ein kompakter, ausdrucksstarker Open-Source-Roboter von Hugging Face, der speziell für menschliche Interaktion, kreatives Programmieren und KI-Experimente entwickelt wurde. Mit nur 28 cm Höhe und 16 cm Breite passt er auf jeden Schreibtisch und ist ab 299 US-Dollar als Bausatz erhältlich. Er ist vollständig in Python programmierbar, unterstützt bald auch JavaScript und Scratch, und bietet dank Kamera, Mikrofonen, Lautsprecher und motorisierter Bewegungen vielfältige Interaktionsmöglichkeiten. Zwei Versionen sind verfügbar: eine kabelgebundene Lite-Version und eine autonome Wireless-Variante mit eingebautem Computer und Akku. Über die Hugging Face Plattform können Nutzer Verhaltensweisen teilen und eigene KI-Anwendungen entwickeln, testen und verbreiten – ideal für Entwickler, Pädagogen und KI-Enthusiasten jeden Alters.

Industrienachrichten

Capgemini setzt auf KI – Milliardenübernahme von WNS stärkt intelligente Geschäftsprozesse

Capgemini übernimmt den Geschäftsprozess-Spezialisten WNS für 3,3 Milliarden US-Dollar in bar und zahlt damit 17 % Aufschlag auf den letzten Börsenkurs. Die Übernahme soll das Umsatzwachstum und die operative Marge sofort stärken. Für 2026 wird ein EPS-Plus von 4 %, für 2027 sogar 7 % nach Synergien erwartet. WNS erzielte 2025 rund 1,27 Milliarden US-Dollar Umsatz bei 18,7 % Marge. Capgemini will mit dem Zukauf seine Position im Bereich KI-gestützter Geschäftsprozesse deutlich ausbauen.

👉 Artikel bei Morningstar | 👉 Mitteilung von Capgemini

Anthropic fordert neue Standards für große KI-Entwickler

Anthropic schlägt ein flexibles Transparenz-Framework für die Entwicklung von Frontier-KI vor. Es richtet sich gezielt an die größten KI-Entwickler und verlangt die öffentliche Offenlegung von Sicherheitsmaßnahmen und sogenannten „Secure Development Frameworks“. Ziel ist es, Risiken wie Missbrauch und Fehlverhalten mächtiger KI-Modelle früh zu erkennen und zu minimieren. Kleine Start-ups werden bewusst ausgenommen, um Innovation nicht zu bremsen. Das Framework sieht außerdem Systemkarten vor, die Tests und Schutzmaßnahmen dokumentieren, sowie strenge Regeln gegen Falschangaben und Schutz für Whistleblower.

👉 Mitteilung von Anthropic | 👉 Transparency Framework

Groq startet erstes europäisches Rechenzentrum in Helsinki und fordert Nvidia heraus

Groq, ein US-amerikanisches KI-Chip-Startup mit einer Bewertung von 2,8 Milliarden Dollar und finanzieller Unterstützung von Samsung und Cisco, hat sein erstes europäisches Rechenzentrum in Helsinki, Finnland, eröffnet. Ziel ist es, die wachsende Nachfrage nach KI-Inferenzlösungen in Europa zu bedienen und die Latenzzeiten zu minimieren. Groq setzt dabei auf seine speziell für KI-Inferenz entwickelten Language Processing Units (LPU), die schneller und effizienter als herkömmliche GPUs arbeiten sollen. Die Partnerschaft mit Equinix ermöglicht Kunden in Europa und den USA schnellen und kostengünstigen Zugriff auf KI-Inferenzkapazitäten. Finnland wurde wegen seiner nachhaltigen Energieversorgung und kühlen Klimas als Standort gewählt.

Schweiz setzt auf Qualität und Ethik im KI-Wettlauf – klein, aber mächtig

Die Schweiz verfolgt im globalen KI-Rennen einen eigenen Weg, der auf Qualität statt Quantität, öffentliche-private Zusammenarbeit und ethische KI-Entwicklung setzt. Mit 3,3% des BIP für Forschung und Entwicklung gehört sie weltweit zu den Top 5, wobei zwei Drittel der Mittel aus der Privatwirtschaft stammen. EPFL und ETH Zürich bündeln über 200 KI-Expert:innen, um unter anderem ein mehrsprachiges, transparentes und Open-Source-Sprachmodell speziell für die Schweiz zu entwickeln. Der Supercomputer Alps unterstützt diese Forschung als zweitstärkster Europas. Zudem fördert die Schweiz mit Bürger:innenversammlungen eine demokratische Debatte über KI und deren gesellschaftliche Auswirkungen.

Mistral AI verhandelt Milliardenfinanzierung für Europas größtes KI-Rechenzentrum

Die französische KI-Startup Mistral AI, bekannt für den Chatbot Le Chat und offene LLM-Modelle, verhandelt mit Investoren, darunter der Abu Dhabi MGX-Fonds, über eine Kapitalerhöhung von bis zu 1 Milliarde US-Dollar. Zusätzlich sucht Mistral Kredite in Höhe von mehreren hundert Millionen Euro bei französischen Geldgebern wie Bpifrance. Das frische Kapital soll vor allem in den Ausbau der KI-Infrastruktur fließen, insbesondere in das gemeinsame Projekt mit MGX und Nvidia zum Bau des größten KI-Rechenzentrums Europas nahe Paris. Mistral, mit einer bisherigen Bewertung von über 6,5 Milliarden Dollar, steht im Zentrum von Präsident Macrons Strategie zur europäischen KI-Souveränität.

Produktneuheiten

Mistral AI hebt Coding-KI mit Devstral Small 1.1 und Medium 2507 auf ein neues Level

Mistral AI hat in Kooperation mit All Hands AI die neuen Modelle Devstral Small 1.1 und Devstral Medium 2507 vorgestellt, die speziell für agentische Programmieraufgaben optimiert sind. Devstral Small 1.1 mit 24 Milliarden Parametern ist Open Source unter Apache 2.0, bietet eine 128k Token Kontextlänge und erreicht eine Spitzenleistung von 53,6% auf dem SWE-Bench Verified – damit ist es das führende offene Modell auf diesem Benchmark. Devstral Medium 2507 erzielt sogar 61,6% und übertrifft Konkurrenten wie Gemini 2.5 Pro und GPT 4.1 bei einem Viertel der Kosten. Beide Modelle sind über API verfügbar, Devstral Medium zudem On-Premise einsetzbar und feinjustierbar, ideal für Unternehmen mit hohen Anforderungen an Leistung und Datenschutz.

MedGemma: Googles leistungsstärkste offene KI-Modelle für die Gesundheitsforschung

Google hat mit MedGemma seine fortschrittlichste offene Modellreihe für Gesundheits-KI vorgestellt, basierend auf der Gemma 3-Architektur. Die Modelle unterstützen multimodale medizinische Text- und Bildverarbeitung, etwa für Radiologiebilder oder klinische Datenanalysen. MedGemma 27B Multimodal und MedSigLIP (ein leichter Bild-Text-Encoder) ermöglichen effiziente, datenschutzfreundliche Anwendungen, die auf einzelnen GPUs oder sogar mobilen Geräten laufen. Die Offenheit erlaubt Entwicklern volle Kontrolle über Anpassungen und Datenschutz, was in der Medizin besonders wichtig ist. MedGemma erreicht bei klinischem Wissen eine Leistung nahe großer Modelle wie GPT-4o und ist frei verfügbar auf Hugging Face.

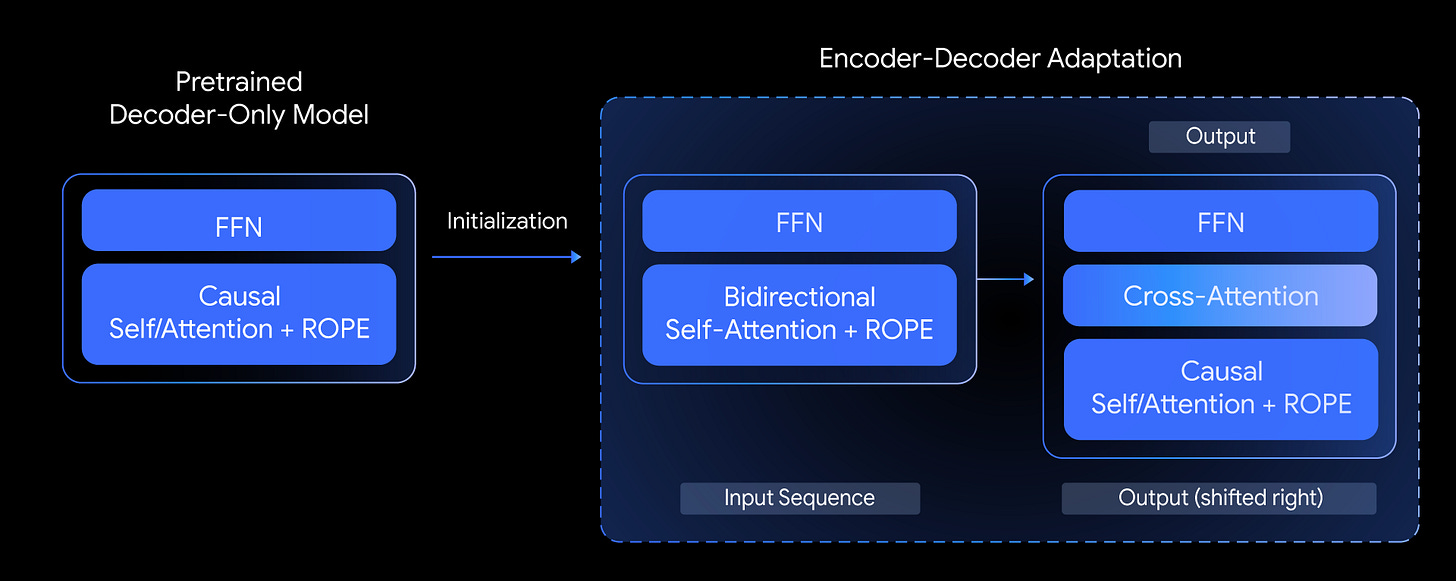

T5Gemma: Encoder-Decoder-Modelle neu gedacht –

Top-Leistung durch Adaptation von Decoder-Only-Modellen

Google stellt mit T5Gemma eine neue Reihe von leistungsstarken Encoder-Decoder-Sprachmodellen vor, die durch die Adaptation bereits vortrainierter Decoder-Only-Modelle (wie Gemma 2) entstehen. Diese Modelle verbinden die Vorteile klassischer Encoder-Decoder-Architekturen – etwa bessere Effizienz bei Aufgaben wie Zusammenfassung, Übersetzung und Fragenbeantwortung – mit der Leistungsstärke moderner Decoder-Only-Modelle. T5Gemma zeigt in Benchmarks wie SuperGLUE und GSM8K eine deutlich bessere oder vergleichbare Performance bei ähnlicher oder sogar besserer Latenz. Besonders flexibel ist die Möglichkeit, „unbalancierte“ Modelle zu bauen (z. B. großer Encoder, kleiner Decoder), um Qualität und Geschwindigkeit optimal auszutarieren. Nach Instruktionstuning übertrifft T5Gemma seine Vorgänger deutlich, was die Architektur als vielversprechenden Weg für zukünftige LLM-Entwicklungen unterstreicht. Die Modelle sind offen verfügbar und bieten neue Chancen für Forschung und Entwicklung.

Zahlen, Studien, Wissenschaft

Proteinfunktion durch skalierbare Emulation von Gleichgewichtszuständen entschlüsselt

Die Studie zeigt, wie Proteinfunktion durch den Übergang zwischen verschiedenen Konformationszuständen gesteuert wird. Ein neu entwickeltes, skalierbares Emulationsverfahren ermöglicht es, diese dynamischen Gleichgewichtszustände von Proteinen präzise nachzubilden. Dies verbessert das Verständnis der molekularen Mechanismen, die Proteine für ihre Funktionen benötigen, und kann die Wirkstoffentwicklung beschleunigen, indem es Einblicke in seltene, funktionell relevante Proteinstrukturen gibt. Die Methode bietet eine effiziente Alternative zu aufwendigen Simulationen und experimentellen Techniken.

Ich wünsche Ihnen ein schönes Wochenende!

Prompt Well and Prosper!

Ihr

Martin Blaha

Das KI-Update ist eine wöchentliche Publikation, die von Martin Blaha (3pconsulting.net) produziert wird. Kontakt- und Geschäftsanfragen gerne über LinkedIn.